Сегодня искусственный интеллект (ИИ), особенно большие языковые модели (LLM), всё чаще становится частью бизнеса: в чат-ботах, голосовых помощниках, email-ассистентах, службах поддержки, автоматизации процессов. Но насколько такие модели по-настоящему понимают людей? А не просто повторяют заученные фразы?

Учёные проверили, насколько хорошо ИИ способен "читать между строк", то есть использовать прагматику — умение учитывать контекст, намерения и ожидания собеседника. Результаты важны для всех, кто использует ИИ в коммуникациях с клиентами. Ниже — конкретные выводы и что они значат для бизнеса и практики.

Что именно проверяли

Учёные протестировали разные языковые модели (от самых маленьких до GPT-4 и Claude) в задаче: понять, какую идею хочет донести человек (или другая модель) с помощью короткой подсказки.

Для этого они использовали специально созданную игру, где:

- Один игрок (или модель) получает шкалу от одного понятия к другому — например, от "Плохое" до "Хорошее".

- И целевое значение, например — 70 из 100.

- Его задача — придумать подсказку (например: "early winter").

- Второй игрок должен по этой подсказке понять, где на шкале точка 70.

Так можно проверить, насколько ИИ понимает не только слова, но и скрытые смыслы — как это делают люди в общении.

5 ключевых выводов и что они значат для бизнеса

1. Крупные языковые модели уже близки к человеческому уровню понимания

Что это значит: Если вы используете модели уровня GPT-4, Claude 3.7 или Qwen3 32B — они уже могут точно понимать намерения клиентов, даже когда речь идёт не о чётких вопросах, а об эмоциях, ассоциациях, намёках.

Как применить:

- Используйте сильные LLM в службах поддержки, где нужно улавливать тон общения.

- В продажах — для интерпретации “тёплых” или “сомневающихся” лидов.

- В обучении персонала — как умный партнёр для симуляции общения с клиентами.

2. Но модели слишком уверены — в отличие от реальных людей

Что это значит: Модели часто дают слишком точный и уверенный ответ, даже если ситуация неоднозначна. А человек, наоборот, может сказать “ну где-то между”, “наверное ближе к тому, но не точно”.

Почему это важно для вас:

- Такая "избыточная уверенность" может привести к тому, что ИИ ошибается, даже не давая понять, что сомневается.

- Это особенно опасно в сферах, где важна точность или этика: юриспруденция, медицина, финансовые консультации.

Как применить:

- При проектировании ИИ-систем добавьте индикаторы уверенности: “возможно”, “скорее всего”, “это один из вариантов”.

- Делайте так, чтобы модель предлагала несколько вариантов в случае сомнений.

3. Добавление "разумного мышления" (RSA) делает ИИ ещё умнее

Что это значит: Когда модель заставляют подумать, как другой человек воспримет её слова, она начинает говорить понятнее, точнее и полезнее. Это называется RSA-подходом — когда ИИ делает не просто “что знаю, то и говорю”, а думает: "что человек подумает, когда это услышит?"

Как применить:

- В чат-ботах и ассистентах применяйте подход Chain-of-Thought + RSA:

- Модель сначала объясняет, как она думает, потом даёт ответ.

- Она может предположить, как клиент это поймёт — и переформулировать.

- Это особенно важно в:

- Продажах и переговорах (нужно предугадывать реакцию),

- Клиентском сервисе (понимать, чего именно ожидает клиент),

- Образовании (подбирать понятные объяснения),

- HR и собеседованиях (понимать эмоции и мотивацию).

4. Для генерации текста RSA особенно эффективен

Что это значит: Модели лучше пишут тексты, которые понятны и полезны людям, если используют RSA — т.е. когда учитывают не только свой смысл, но и как это будет воспринято читателем.

Как применить:

- В контенте (письма, лендинги, соцсети): при генерации текстов — давайте команде или модели задачу “как бы ты сказал это, чтобы тебя поняли правильно?”

- В email-маркетинге: генерируйте несколько вариантов письма для разных восприятий — рациональное, эмоциональное, экспертное.

- В продуктовых текстах: делайте акцент не на “что сказать”, а на “как это прочтут”.

5. Модели не всегда делают это сами — им нужно помочь

Что это значит: Без специальных инструкций модели не начинают думать как человек. Им нужно задать нужную форму мышления: “представь, что ты объясняешь это ребёнку”, “что подумает человек, если ты скажешь это?” и т.п.

Как применить:

- Используйте промпты с контекстом: “Твоя задача — объяснить это новичку...”, “Ты пишешь письмо клиенту, который не доволен…”

- Интегрируйте Chain-of-Thought (CoT) в общение модели:

- “Подумай шаг за шагом…”

- “Какие ещё возможные интерпретации?” и т.д.

- Это помогает ИИ работать более мягко, гибко и человечно.

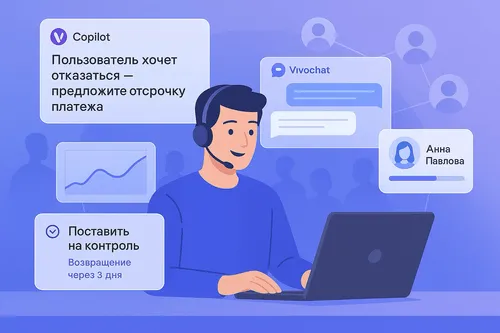

Пример применения: чат-бот в службе поддержки

Разница очевидна — RSA-подход добавляет эмпатию, контекст и заботу.

Выводы

- Современные модели уже очень хороши, особенно в понимании смысла.

- Но не похожи на людей в уровне уверенности — могут ошибиться, не показывая сомнения.

- RSA — мощный инструмент, который делает ИИ более человечным, гибким и разумным.

- Бизнес, который начнёт использовать такие подходы уже сейчас, получит преимущество:

- лучшее качество обслуживания,

- более убедительный маркетинг,

- более точные инсайты в данных клиентов.

Хотите, чтобы ваш ИИ не просто говорил, а по-настоящему понимал?

Научите его думать, как человек думает о другом человеке.